Alors que les organisations s’efforcent d’intégrer l’IA dans leurs flux de travail, beaucoup négligent cette dure réalité : l’IA n’est sécurisée que si les données qui l’alimentent le sont.

Qu’il s’agisse de l’entraînement des modèles sur des documents internes ou du déploiement de copilotes et d’assistants d’IA qui interagissent avec des systèmes en direct, chaque système d’IA héberge d’énormes volumes de données, dont beaucoup sont sensibles, propriétaires ou réglementées.

Dans ce guide, vous apprendrez ce que signifie réellement la sécurité des données de l’IA, les risques uniques qu’elle peut poser à votre environnement, et vous découvrirez des conseils pour déployer l’IA en toute confiance tout en assurant la sécurité des informations sur l’ensemble du cycle de vie des données.

Comprendre le paysage de la sécurité des données de l'IA

Commençons par définir la sécurité de l’IA, qui englobe la protection des informations sensibles dans les outils, les charges de travail et l’infrastructure de l’IA.

Dans le paysage actuel de l’IA, ces composants nécessitent de porter une attention particulière à la sécurité :

- Copilotes IA : des outils tels que Microsoft 365 Copilot, qui assistent les utilisateurs dans diverses tâches.

- Agents IA : des agents qui s’appuient sur les autorisations des utilisateurs pour exécuter des actions spécifiques à grande échelle.

- Grands modèles linguistiques (LLM) : les modèles fondamentaux utilisés par les copilotes et les agents IA, qui génèrent des réponses textuelles similaires à celles d’un humain sur la base de prompts

- Infrastructure IA : les systèmes sous-jacents et les dépôts de données qui alimentent les workloads d’IA.

Pourquoi ces outils nécessitent-ils des mesures de sécurité ? Parce que l’IA introduit plusieurs risques pour les données de l’entreprise que les dirigeants doivent reconnaître, faute de quoi la probabilité d’une violation ou d’une fuite de données augmente. Ces risques comprennent :

- Injection de prompt : les attaquants manipulent les entrées de l’IA pour que le modèle exécute des actions non intentionnelles ou malveillantes.

- Compromission d’identité : accès non autorisé à l’identité d’un utilisateur pour se faire passer pour lui et accéder à des systèmes ou à des données sensibles.

- Menaces internes : individus au sein d’une organisation qui abusent de leur accès pour compromettre des données, par malveillance ou par négligence.

- Exfiltration de données d’entraînement : Extraction non autorisée d’informations sensibles ou propriétaires utilisées pour entraîner un modèle d’IA, souvent par le biais de requêtes ou de sorties de modèles.

- Jailbreaking : une technique utilisée pour contourner les contrôles de sécurité ou les restrictions d’un modèle d’IA, qui permet de générer des contenus nuisibles ou non autorisés.

Imaginez une entreprise de services financiers qui met en œuvre Microsoft 365 Copilot pour améliorer la productivité sans contrôles de sécurité adéquats. Les employés peuvent exposer des données par inadvertance en demandant à l’outil des « informations sur les salaires » et en découvrant qu’ils ont accès à des informations sensibles hors du cadre de leurs autorisations normales.

Les principaux défis de la sécurité des données de l’IA

Au cœur de la sécurité de l’IA, il y a la sécurité des données. Étant donné que les outils d’IA dépendent des informations que vous leur fournissez, la sécurisation des données sensibles avant d’activer l’IA dans votre organisation doit être une priorité absolue.

Voici les domaines principaux que les organisations équipées de l’IA doivent aborder :

Contrôle du rayon d’exposition de l’IA

Les systèmes d’IA nécessitent l’accès à de vastes quantités de données pour fonctionner efficacement. Cela crée ce que nous aimons appeler le rayon d’exposition, soit l’étendue potentielle des dommages auxquels vous pourriez être confronté si quelque chose tourne mal.

Pour minimiser leur rayon d’exposition, les organisations doivent :

- Obtenir une visibilité complète sur les données sensibles auxquelles les systèmes d’IA peuvent accéder ou que les utilisateurs peuvent facilement télécharger lors des sessions d’IA.

- Identifier et révoquer les autorisations excessives dans l’ensemble de l’organisation (celles qui ne sont pas nécessaires au fonctionnement de l’IA)

- Détecter et corriger les erreurs de configuration à risque des systèmes d’IA avant qu’elles ne conduisent à des failles de sécurité

Par exemple, si un système d’IA dispose d’un accès excessif aux données sensibles des clients, une mauvaise configuration peut exposer ces informations dans ses réponses ou les stocker d’une manière qui viole les exigences de conformité, ce qui peut faire croître votre rayon d’exposition de manière exponentielle.

Gestion des informations générées par l'IA

Les systèmes d’IA ne se contentent pas de consommer des données : ils les créent.

Le contenu généré par l’IA peut aussi inclure des informations sensibles qui nécessitent une protection. Il est important de mettre en place une stratégie pour bien classer, étiqueter et surveiller ces données.

Voici comment les organisations peuvent gérer les informations générées par l'IA :

- Mettre en œuvre des systèmes pour classer les contenus générés par l’IA selon leur sensibilité.

- Appliquer les étiquettes de sensibilité appropriées pour garantir une gestion correcte

- Surveiller les niveaux élevés d’interactions sensibles et de création de fichiers et générer des alertes

Par exemple, une organisation de soins de santé peut utiliser l’IA pour analyser les dossiers des patients. Les informations générées peuvent contenir des PHI qui nécessitent des contrôles de sécurité spécifiques. Sans supervision de la sécurité de l’outil d’IA, ces informations de santé sensibles sont désormais exposées et risquent d’apparaître dans d’autres conversations.

Prévention de l’exposition des données sensibles dans les LLM

Les grands modèles de langage (LLM) représentent également un défi particulier pour la sécurité des données.

Leur capacité à traiter de grandes quantités d’informations et à apprendre à partir d’elles crée des risques lorsque des données sensibles sont incluses par inadvertance dans les données d’entraînement ou les prompts.

Lors de la sécurisation des LLM contre les risques de données, les organisations doivent :

- Découvrir et inventorier toutes les charges de travail d’IA dans votre environnement

- Identifier les flux de données sensibles vers et depuis les systèmes d'IA

- Mapper les comptes IA qui ont accès aux dépôts de données sensibles

Imaginez une équipe juridique dans laquelle un avocat utilise un LLM pour l’aider à rédiger des contrats. Sans configuration appropriée, des informations confidentielles sur les clients peuvent être incluses dans les prompts, ce qui peut compromettre le secret professionnel de l’avocat.

Élaborer une stratégie complète de sécurité de l'IA

Avec le potentiel de l’IA de rendre votre rayon d’exposition très large, les organisations doivent aborder les défis de la sécurité de l’IA avec une approche multifacette.

Créer une défense continue contre les risques de l’IA

Les données sont en constante évolution et en constante croissance. La façon dont les utilisateurs accèdent aux données avec l’IA évolue de même constamment. Les évaluations ponctuelles ne peuvent pas suivre l’évolution constante des données. Par conséquent, un élément central de votre stratégie de sécurité des données doit être la surveillance continue et la remédiation pour vous protéger contre les risques liés à l’IA.

Le NIST AI Risk Management Framework (AI RMF) met en avant cette pratique précise, en déclarant notamment que les organisations doivent s’assurer que « les risques et les avantages de l’IA provenant de ressources tierces sont régulièrement surveillés, et que les contrôles des risques sont appliqués et documentés ».

Plus précisément, une stratégie efficace de sécurité de l’IA comprend :

- Le contrôle en temps réel des systèmes d’IA tiers et des données auxquelles ils ont accès

- Le verrouillage automatique des données sensibles avant que des violations d’IA ne se produisent

- Des indicateurs quantifiables pour démontrer la réduction des risques au fil du temps

Découverte et classification des données d'IA

Il est impossible de protéger ce que vous ne voyez pas.

Les capacités complètes de découverte et de classification des données sont fondamentales pour la sécurité de l’IA. Lorsque vous élaborez votre stratégie, gardez à l’esprit les points suivants :

- Identifiez et classez les données créées par l’homme et celles générées par l’IA

- Ayez une compréhension du lignage des données, c’est-à-dire d’où proviennent les données et comment elles circulent dans les systèmes

- Veillez à ce que les employés n’aient accès qu’aux informations sensibles dont ils ont besoin pour leur rôle.

Informations sur les accès de l'IA

Il est crucial de comprendre et de contrôler quels systèmes d’IA et quels utilisateurs peuvent accéder aux données sensibles.

Les organisations peuvent faire ce qui suit pour intégrer l’intelligence d’accès à l’IA dans leur stratégie :

- Ayez une visibilité bidirectionnelle sur les utilisateurs activés par l’IA qui peuvent accéder aux données sensibles

- Identifiez et révoquez automatiquement les autorisations obsolètes ou excessives

- Assurer une séparation adéquate des tâches entre les systèmes d’IA et les dépôts de données sensibles

Détection d'utilisation anormale de l'IA

Même avec des contrôles de sécurité appropriés en place, il est essentiel de surveiller le comportement anormal des systèmes d’IA. Les cyberattaques basées sur l’identité atteignent des niveaux sans précédent, et de graves conséquences – telles que les violations de données – peuvent survenir si vous ne recherchez pas activement les menaces dans votre environnement.

Pour détecter une utilisation anormale de l'IA, les organisations devraient :

- Surveiller les prompts et les réponses de l’IA pour détecter les violations de politique

- Établir des bases de comportement pour les systèmes d’IA et les utilisateurs

- Générer des alertes lorsque des schémas inhabituels sont détectés.

Préparation aux exigences de conformité de l’IA

Alors que l’adoption de l’IA s’accélère, les cadres réglementaires évoluent pour aborder les risques associés que nous avons mentionnés.

Le règlement européen sur l’IA, par exemple, introduit de nouvelles exigences de conformité pour les organisations qui utilisent des systèmes d’IA et a inspiré d’autres réglementations.

Les organisations peuvent garder à l’esprit la conformité lors du déploiement des outils d’IA :

- En comprenant les réglementations émergentes concernant l’IA dans les juridictions concernées et en préparant votre organisation à s’y conformer à l’avenir ;

- En documentant l’utilisation du système d’IA, y compris les flux de données et les contrôles d’accès ;

- En mettant en œuvre des contrôles qui démontrent la conformité aux exigences propres à l’IA.

Les entreprises multinationales peuvent avoir besoin d’établir des contrôles distincts pour les systèmes d’IA utilisés dans l’UE par rapport à ceux utilisés dans d’autres régions, en s’assurant que chaque déploiement respecte les exigences réglementaires locales.

Déployer l'IA en toute sécurité avec une approche unifiée

Plutôt que de traiter la sécurité de l’IA avec des solutions ponctuelles déconnectées, un nombre croissant d’organisations adoptent des plateformes unifiées qui offrent une visibilité et un contrôle complets.

Cette approche unifiée comprend généralement :

- Une visibilité en temps réel de votre posture de sécurité des données sur tous les systèmes d’IA et les dépôts de données ;

- Des capacités de prévention automatisées qui réduisent continuellement votre rayon d’exposition potentiel de l’IA ;

- Une détection proactive des menaces grâce à l’analyse du comportement des utilisateurs et des entités centrée sur les données.

Imaginons une société pharmaceutique qui développe de nouveaux médicaments avec l’aide de l’IA. Dans ce scénario, une approche de sécurité unifiée consisterait à :

- Découvrir et classer automatiquement les données de recherche dans tous les environnements ;

- Contrôler quels outils d'intelligence artificielle peuvent accéder à différentes catégories d'informations de recherche

- Surveiller les schémas d’accès inhabituels qui peuvent indiquer des tentatives de vol de données ;

- Remédier automatiquement aux problèmes d’autorisation avant qu’ils n’entraînent une exposition de l’IA.

Renforcer la sécurité de l’IA avec Varonis

Les organisations ont besoin d’une visibilité approfondie et continue sur l’emplacement des données sensibles, qui peut y accéder et comment elles sont utilisées pour sécuriser les données destinées à l’IA – ce qui n’est pas réalisable manuellement.

Varonis aide les organisations à protéger les données qui alimentent les systèmes d’IA et qui sont impactés par eux chaque seconde, partout.

Que vous formiez des modèles à partir de documents internes, utilisiez l’IA générative pour assister les employés ou gériez des outils d’IA tiers, Varonis vous offre les informations et le contrôle nécessaires pour sécuriser vos actifs de données les plus précieux.

Notre plateforme de sécurité des données (DSP) offre aux organisations :

- La découverte et la classification des données d’IA : obtenez une classification complète, actuelle et contextuelle de vos données humaines et générées par l’IA, quelle que soit la taille de vos dépôts de données.

- L’intelligence d’accès à l’IA : comprenez quels utilisateurs et comptes IA peuvent accéder à des données sensibles et révoquez automatiquement les autorisations obsolètes ou excessives sans interruption.

- La détection des utilisations anormales de l’IA : surveillez les prompts et établissez des bases de comportement pour chaque utilisateur et appareil afin de détecter les actions qui enfreignent la politique, se comportent de manière anormale ou sont compromises.

Voici d'autres capacités uniques de notre DSP qui vous aident à sécuriser l'IA :

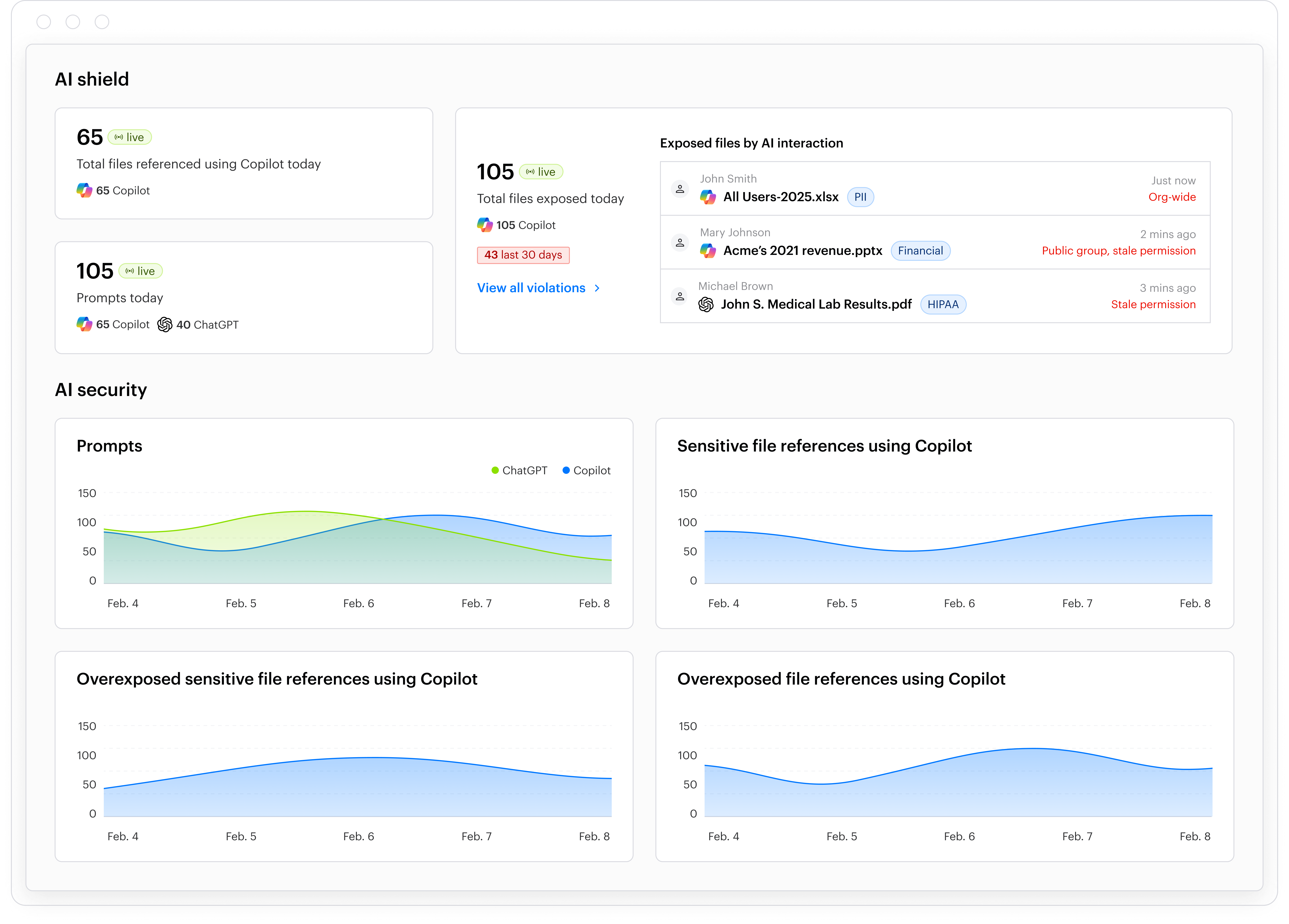

Varonis AI Security : votre défense IA toujours en marche

Varonis AI Security identifie en permanence les risques liés à l’IA en temps réel, signale les violations actives et corrige automatiquement les problèmes avant qu’ils ne deviennent des fuites de données. Grâce à des résultats quantifiables, vous, votre équipe de direction et les auditeurs pouvez voir quel est le risque lié à l’IA de votre organisation et comment il diminue au fil du temps.

AI Security prend des décisions intelligentes sur les données dont l’utilisation par l’IA doit être restreinte en utilisant des algorithmes de recommandation d’autorisations brevetés de Varonis qui prennent en compte la sensibilité des données, leur obsolescence, le profil utilisateur, et d’autres paramètres. Même si vous n’avez pas ajusté l’accès correctement, AI Security vous protège.

Avec Varonis AI Security, les clients bénéficient de défenses permanentes pour sécuriser l’utilisation de l’IA, notamment :

- Analyse des risques en temps réel pour vous montrer exactement quelles données sensibles sont exposées à l'IA

- La remédiation automatisée des risques pour éliminer en continu l’exposition des données à grande échelle

- Détection des menaces basée sur le comportement pour identifier les comportements anormaux ou malveillants

- La réponse aux alertes 24 h/24, 7 j/7, 365 j/an pour enquêter sur les menaces, les arrêter et isoler celles qui pèsent sur les données avec Varonis MDDR

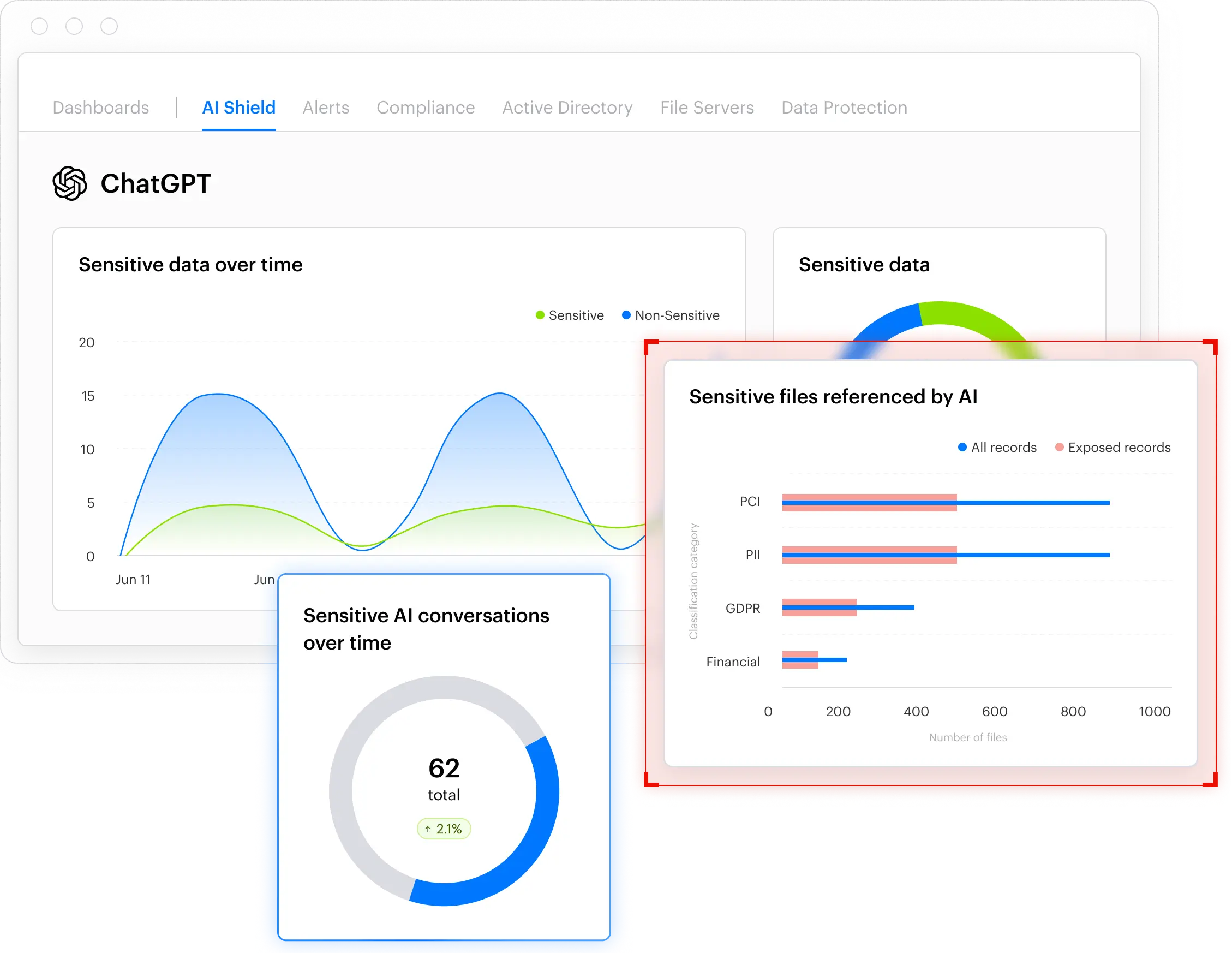

Le tableau de bord d’AI Security affiche en temps réel vos risques réels liés à l’IA, notamment les violations de politiques et les requêtes suspectes.

Le tableau de bord d’AI Security affiche en temps réel vos risques réels liés à l’IA, notamment les violations de politiques et les requêtes suspectes.

Athena AI

Athena AI est intégré à la plateforme Varonis de sécurité des données et aide à combler le déficit de compétences tout en accélérant considérablement les tâches de sécurité et de conformité.

Grâce à cet outil, vous pouvez utiliser le langage naturel pour mener des enquêtes et des analyses approfondies plus efficacement, ce qui transforme tous vos utilisateurs en de redoutables défenseurs des données.

Varonis pour Microsoft 365 Copilot

Le modèle de sécurité de Microsoft 365 Copilot s’appuie sur les autorisations Microsoft 365 existantes de l’utilisateur pour déterminer quels fichiers, e-mails, conversations, notes, etc., peuvent être utilisés pour générer des réponses d’IA.

Si les autorisations ne sont pas correctement ajustées avant d’activer un outil d’IA comme celui-ci dans votre environnement, la surface d’exposition et la probabilité d’une fuite de données augmentent considérablement.

Varonis pour Microsoft 365 Copilot offre des contrôles de sécurité essentiels pour optimiser votre déploiement de Copilot et sécuriser continuellement vos données après le déploiement de l’outil.

Les principales caractéristiques comprennent :

- Limitation de l’accès : contrôlez l’accès aux données sensibles pour éviter toute exposition involontaire

- Surveillance des prompts : gardez un œil sur les prompts de Copilot en temps réel

- Détection des abus : Identifier tout usage abusif ou comportement anormal

Ensemble, Varonis et Microsoft s’engagent à aider les entreprises à déployer l’IA en toute confiance, tout en évaluant et en améliorant constamment la sécurité des données de Microsoft 365 en coulisses, avant, pendant et après le déploiement. En savoir plus sur notre partenariat avec Microsoft.

Identifiez rapidement quand les conversations avec Copilot semblent malveillantes, et faites apparaître les données sensibles.

Identifiez rapidement quand les conversations avec Copilot semblent malveillantes, et faites apparaître les données sensibles.

Varonis pour Agentforce

Salesforce prend également en charge l’IA grâce à l’utilisation d’agents. Son agent d’IA, Agentforce, hérite des autorisations des utilisateurs qui les exécutent. Ainsi, si les utilisateurs ont un accès excessif, l’agent peut exposer des données sensibles.

Réduire votre rayon d’exposition, surveiller l’activité des agents et détecter les utilisations anormales sont essentiels pour assurer la sécurité des agents d’IA.

Varonis permet aux équipes de sécurité et aux administrateurs de Salesforce d’identifier les données sensibles, de calibrer l’accès à ces données et de prévenir les activités non autorisées dans l’ensemble de leurs environnements Salesforce, notamment Agentforce et d’autres applications SaaS.

Enquêtez sur les prompts d’Agentforce qui entraînent la divulgation d’informations sensibles et vérifiez si les fichiers ont été consultés.

Enquêtez sur les prompts d’Agentforce qui entraînent la divulgation d’informations sensibles et vérifiez si les fichiers ont été consultés.

Varonis pour ChatGPT Enterprise

Varonis complète ChatGPT Enterprise en ajoutant une sécurité des données continue et de pointe ainsi qu’une surveillance 24 h/24 et 7 j/7, ce qui aide les organisations à adopter l’IA avec plus d’assurance.

Varonis ajuste en permanence les autorisations dans l’environnement informatique d’une organisation, limitant ainsi le flux involontaire de données sensibles vers les applications d’IA et les LLM. Grâce à cette nouvelle intégration, Varonis fournit une surveillance supplémentaire de la manière dont les utilisateurs interagissent avec ChatGPT et alerte les équipes de sécurité en cas de comportement anormal et risqué.

Comme les utilisateurs copient et chargent des données depuis toutes sortes de ressources, ce manque de visibilité peut entraîner une surexposition ou des fuites de données. Varonis sort ChatGPT de l'ombre.

Comme les utilisateurs copient et chargent des données depuis toutes sortes de ressources, ce manque de visibilité peut entraîner une surexposition ou des fuites de données. Varonis sort ChatGPT de l'ombre.

La couverture de notre plateforme ne s’arrête pas là. Varonis peut également s’intégrer à AWS, Azure, ServiceNow, Snowflake, Databricks et plus encore pour protéger vos informations où qu’elles se trouvent. Explorez nos options de couverture.

Réduisez vos risques sans en prendre aucun.

Êtes-vous prêt à découvrir comment Varonis peut renforcer votre posture de sécurité des données IA ?

Commencez par une évaluation gratuite des risques liés à l’IA. En moins de 24 heures, vous disposerez d’une vue claire, basée sur les risques liés aux données les plus importantes et d’un parcours clair vers la remédiation automatisée.

Pendant l’évaluation, vous aurez un accès complet à notre plateforme et à un analyste dédié de réponse aux incidents. Même si vous décidez de ne pas choisir Varonis, les résultats de votre évaluation vous appartiennent, sans aucune condition.

Demandez votre évaluation dès aujourd’hui.

En savoir plus sur la sécurité de l'IA

Curieux de savoir comment fonctionne le modèle d’autorisation de Microsoft Copilot ? Cherchez-vous des étapes pour déployer Agentforce? Peut-être avez-vous besoin de plus d’informations sur les serveurs MCP ?

Pour en savoir plus sur la sécurité des données de l’IA, consultez nos autres articles :

Que dois-je faire maintenant ?

Vous trouverez ci-dessous trois solutions pour poursuivre vos efforts visant à réduire les risques liés aux données dans votre entreprise:

Planifiez une démonstration avec nous pour voir Varonis en action. Nous personnaliserons la session en fonction des besoins de votre organisation en matière de sécurité des données et répondrons à vos questions.

Consultez un exemple de notre évaluation des risques liés aux données et découvrez les risques qui pourraient subsister dans votre environnement. Cette évaluation est gratuite et vous montre clairement comment procéder à une remédiation automatisée.

Suivez-nous sur LinkedIn, YouTube et X (Twitter) for pour obtenir des informations sur tous les aspects de la sécurité des données, y compris la DSPM, la détection des menaces, la sécurité de l’IA et plus encore.

-1.png)