Si l’IA générative a permis une nouvelle vague de productivité, elle a également créé une nouvelle catégorie dans les risques de sécurité.

À mesure que les outils et les plateformes d’IA deviennent plus accessibles et puissants, les employés les adoptent sans supervision informatique. En fait, notre rapport sur l’état de la sécurité des données 2025 a révélé que 98 % des employés utilisent des applications non autorisées dans le cadre de la shadow AI et du shadow IT.

Bien qu’elle puisse sembler inoffensive, la shadow AI peut exposer vos données sensibles, compromettre la conformité et introduire des vulnérabilités invisibles dans votre environnement. Dans cet article, vous découvrirez ce qu’est la shadow AI, pourquoi elle est risquée pour les entreprises et comment y remédier sans étouffer l’innovation.

Qu’est-ce que la shadow AI ?

La Shadow AI désigne l’utilisation d’outils et d’applications d’intelligence artificielle par les employés sans approbation ni gouvernance formelles de la part de leurs services informatiques. Tout comme le shadow IT, la shadow AI implique spécifiquement des modèles d’IA générative, des agents, des copilotes, des outils et d’autres systèmes d’IA qui n’ont pas fait l’objet de processus de vérification de sécurité appropriés.

Avec la croissance explosive des plateformes d’IA simples d’utilisation, les employés peuvent facilement accéder à de puissantes capacités d’IA. La commodité, la rentabilité, les fonctionnalités avancées et la nature open source des outils d’IA les rendent attrayants pour tout employé cherchant à augmenter sa productivité, mais cela comporte des risques cachés non négligeables. La récente interdiction de Deepseek par le Congrès américain a mis en lumière les préoccupations critiques de sécurité de la shadow AI.

La menace croissante de la shadow AI pour la sécurité

Les implications de la shadow AI en matière de sécurité vont bien au-delà des risques logiciels habituels. Les employés qui saisissent des données d’entreprise dans des systèmes d’IA non autorisés peuvent, par inadvertance, exposer des informations sensibles à des entités externes qui ont des pratiques de traitement des données douteuses.

Voici ce à quoi vous devez faire attention lorsque vous déterminez comment vos données sont traitées par les plateformes d’IA :

Préoccupations relatives au traitement des données

Examinons DeepSeek, une plateforme d’IA populaire. Conformément à sa politique de confidentialité, DeepSeek traite les prompts des utilisateurs sur des serveurs situés en Chine.

Cela signifie :

- Toutes les données soumises à la plateforme sont soumises aux lois et réglementations chinoises sur la confidentialité des données

- Les organisations peuvent être confrontées à des problèmes de conformité aux exigences réglementaires américaines

- Les informations sensibles peuvent être traitées en dehors du périmètre de sécurité de votre organisation

- La souveraineté des données devient une préoccupation importante pour les industries réglementées

Bien que les développeurs puissent héberger des instances locales de DeepSeek sur des serveurs isolés, de nombreux employés utilisent simplement la version publique sans prendre en compte ces implications.

Exposition d’informations sensibles

Imaginons, par exemple, qu’un représentant commercial colle un contrat client dans un outil d’IA pour aider à récapituler les points clés d’une réunion. Sans s’en rendre compte, il a potentiellement exposé des structures de prix confidentielles, des informations sur les clients et des conditions exclusives sur des serveurs qui ne sont pas contrôlés par l’entreprise. Ces données peuvent être intégrées aux données d’apprentissage de l’IA ou être accessibles à des parties non autorisées.

L’acte en lui-même semble assez insignifiant, mais ce type de fuite de données involontaire représente l’un des risques les plus importants associés à la shadow AI.

Pourquoi les interdictions traditionnelles ne fonctionnent-elles pas sur la shadow AI ?

De nombreuses organisations ont géré la shadow AI en mettant en place des interdictions sur des outils comme DeepSeek. Des gouvernements, et des pays entiers comme l’Italie, ont pris des mesures pour bloquer certaines plateformes d’IA afin de se protéger contre les risques liés à la shadow AI.

Les interdictions conventionnelles des entreprises se sont cependant révélées difficiles à faire respecter pour plusieurs raisons :

- Les employés trouvent des solutions de contournement lorsqu’ils pensent que l’IA peut aider à améliorer la productivité

- Les appareils personnels et les réseaux domestiques fournissent des points d’accès alternatifs

- Le nombre croissant d’outils d’IA rend un blocage complet impossible à mettre en œuvre.

- Les employés peuvent ne pas comprendre les implications de leurs actions en matière de sécurité.

Rejoignez-nous pour notre prochain webinaire, Shining a Light on Shadow AI.

Le défi unique de l'IA open-source

Si des applications telles que TikTok ou du matériel d'entreprise comme Huawei suscitent déjà des inquiétudes, les outils d'IA open-source posent des problèmes de sécurité différents.

Modèles open source :

- Permettent aux cybercriminels de lancer des campagnes massives plus efficacement grâce à leur faible coût d’entraînement et de fonctionnement.

- Créent des défis pour les organisations qui cherchent à identifier quand et comment ces outils sont utilisés.

- Possèdent un code qui peut être modifié et déployé de manière à échapper à la détection.

- Augmentent la vulnérabilité aux attaques ciblées en raison de la transparence des modèles open source

Stratégies efficaces d’atténuation des risques liés à la shadow AI

Le tableau n’est pas si sombre : les organisations peuvent encore profiter des avantages de l’IA. Plutôt que de bloquer ou d’interdire tous les outils d’IA, les organisations peuvent mettre en œuvre ces stratégies pour gérer les risques liés à la shadow AI tout en tirant parti des avantages de l’IA.

Élaborer des politiques claires en matière d’IA

Les organisations peuvent commencer à atténuer les risques liés à l’IA en établissant et en communiquant des directives claires concernant les outils d’IA approuvés et leur utilisation.

Les politiques typiques incluent :

- Créez des protocoles spécifiques pour le traitement des informations sensibles

- Définissez les conséquences de l’utilisation d’outils d’IA non autorisés

- La mise en place de canaux clairs pour demander l’accès aux nouveaux outils d’IA.

- La mise à jour des politiques de classification des données pour prendre en compte les risques propres à l’IA.

Par exemple, une équipe de marketing peut élaborer des lignes directrices qui permettent l’utilisation d’outils d’IA approuvés pour la génération d’idées de campagne, mais celle-ci devra faire l’objet d’une révision humaine avant l’utilisation de tout contenu généré par l’IA.

Proposez des alternatives sûres

Lorsque les employés se tournent vers la shadow AI, cela indique souvent qu’ils ont besoin de capacités qui ne sont pas fournies par les canaux officiels.

Pour combattre cela, les organisations doivent :

- Envisagez de créer des instances isolées en utilisant du code open source

- Évaluez les solutions d’IA professionnelles avec des contrôles de sécurité appropriés

- Implanter des versions cloisonnées qui ne se connectent pas à des serveurs externes

- Créer des sandbox internes dotés d’IA où les employés peuvent faire des expériences en toute sécurité

Les équipes de développement de logiciels, par exemple, peuvent bénéficier d’assistants de codage hébergés en interne qui les aident dans leurs tâches sans exposer leur code propriétaire à des plateformes d’IA externes.

Donner la priorité à l'éducation des employés

De nombreux risques liés à l’IA fantôme proviennent d’un manque de sensibilisation plutôt que d’une intention malveillante. Il est de la responsabilité des organisations qui souhaitent mettre en œuvre l’IA de :

- Sensibiliser le personnel aux risques de sécurité des données associés aux outils d’IA.

- Fournir des alternatives claires aux applications d’IA non autorisées

- Expliquer les implications du partage d’informations sensibles avec des modèles d’IA

- Créer des cadres de décision simples pour déterminer quand l'utilisation de l'IA est appropriée

Mettre en œuvre des contrôles techniques

Les solutions techniques offrent de solides capacités dans la gestion de la shadow AI. Afin de sécuriser leur environnement pour l’IA, les organisations peuvent :

- Déployer des outils de prévention des pertes de données (DLP), pour identifier les données sensibles partagées avec les plateformes d’IA.

- Utiliser la surveillance du DNS et du proxy web pour détecter toute utilisation non autorisée de l’IA.

- Mettre en œuvre un accès de moindre privilège pour minimiser l’exposition potentielle.

- Auditer régulièrement les intégrations d’applications pour identifier les outils de shadow AI

Permettre l’innovation en shadow AI, mais avec sécurité

La clé pour gérer efficacement la shadow AI dans une organisation réside dans l’équilibre entre l’innovation et le maintien de la sécurité. Trouver cet équilibre signifie :

- Créer des voies claires pour que les employés puissent demander de nouvelles capacités d'IA

- Établir des cadres d’évaluation des risques spécifiquement pour les outils d’IA

- Révisez et mettez à jour régulièrement les politiques d’IA à mesure que la technologie évolue

- Intégrer les unités opérationnelles dans les décisions de gouvernance de l’IA

Découvrir et gérer la shadow AI avec Varonis

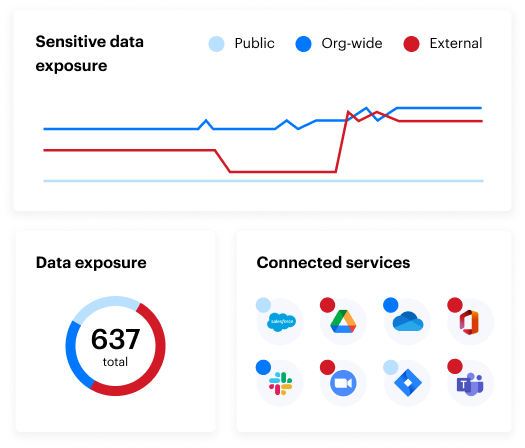

Des outils spécialisés comme Varonis permettent aux organisations d’identifier l’utilisation de la shadow AI et de relever ses défis grâce à des fonctionnalités telles que :

- Les capacités de surveillance du réseau, qui détectent l’utilisation des outils d’IA à l’aide des journaux DNS et des proxy web

- La fonctionnalité SSPM, qui identifie et supprime automatiquement les applications et les plugins de la shadow AI intégrés dans les applications SaaS autorisées sans l’approbation du service informatique.

- Le suivi de l’activité des utilisateurs, pour déterminer quels employés ont installé des applications d’IA, quand ils l’ont fait et quelles actions ont été réalisées

- Les outils de découverte et de classification des données, capables d’identifier les fichiers, le code source, les e-mails et d’autres contenus liés à des outils d’IA non autorisés

Vous souhaitez en savoir plus sur la posture de votre organisation en matière de sécurité des données ? Profitez de notre évaluation gratuite des risques liés aux données.

Les risques cachés de la shadow AI : FAQ

Qu’est-ce que la shadow AI ?

La shadow AI désigne la pratique des employés qui utilisent des outils et des applications d’intelligence artificielle sans approbation ni gouvernance officielles de la part des services informatiques. À l’instar du shadow IT, où les employés adoptent des logiciels ou du matériel non autorisés, la shadow AI implique spécifiquement des modèles d’IA générative, des outils d’apprentissage automatique et d’autres systèmes d’IA qui n’ont pas été soumis à des processus de vérification de sécurité appropriés.

Quels sont les risques de la shadow AI ?

Les risques de la shadow AI incluent :

- L’exposition de données sensibles de l’entreprise à des entités externes, dont les pratiques en matière de traitement des données sont douteuses

- Problèmes de conformité aux exigences réglementaires lorsque les données sont traitées dans différentes juridictions

- Préoccupations concernant la souveraineté des données pour les industries réglementées

- Fuite involontaire d'informations propriétaires

- Le traitement potentiel des données de l’entreprise sur des serveurs dont les contrôles de sécurité sont inconnus.

Quelques exemples de shadow AI

Un exemple de shadow AI peut être des employés qui utilisent des outils comme ChatGPT ou des LLM open source (tels que DeepSeek) pour écrire du code, analyser des données, générer du contenu marketing ou récapituler des contrats de clients, le tout sans approbation informatique ni examen de sécurité.

Comment les organisations peuvent-elles détecter l’utilisation de l’IA fantôme ?

La shadow AI peut entraîner une non-conformité avec des réglementations telles que le GDPR, l’HIPAA ou le CCPA si des données sensibles sont traitées dans des environnements non autorisés ou non réglementés, notamment au-delà des frontières nationales.

En quoi la shadow AI est-elle différente du shadow IT ?

La shadow AI est un sous-ensemble du shadow IT axé explicitement sur l’utilisation non autorisée d’outils d’intelligence artificielle. Alors que le shadow IT inclut tout matériel ou logiciel non approuvé, la shadow AI crée des risques uniques en matière de confidentialité des données et d’entraînement des modèles.

Que dois-je faire maintenant ?

Planifiez une démonstration avec nous pour voir Varonis en action. Nous personnaliserons la session en fonction des besoins de votre organisation en matière de sécurité des données et répondrons à vos questions.

Consultez un exemple de notre évaluation des risques liés aux données et découvrez les risques qui pourraient subsister dans votre environnement. Cette évaluation est gratuite et vous montre clairement comment procéder à une remédiation automatisée.

Suivez-nous sur LinkedIn, YouTube et X (Twitter) for pour obtenir des informations sur tous les aspects de la sécurité des données, y compris la DSPM, la détection des menaces, la sécurité de l’IA et plus encore.