Une vulnérabilité récemment révélée dans Microsoft 365 Copilot, nommée EchoLeak, suscite des inquiétudes au sein de la communauté de la sécurité.

Découvert par Aim Labs, cet exploit permet aux attaquants d’exfiltrer des données sensibles de la fenêtre contextuelle de Copilot sans hameçonnage et avec une interaction minimale de l’utilisateur.

La chaîne d’attaque, appelée LLM Scope Violation, manipule les mécanismes internes des grands modèles de langage pour contourner les mesures destinées à arrêter les attaques par injection de prompts, comme les classificateurs XPIA.

Résultat ? Des informations sensibles et confidentielles peuvent être extraites discrètement de Copilot, même si l’interface est réservée aux utilisateurs internes. Il suffit d’un simple e-mail contenant des instructions presque imperceptibles qui déclenchent l’extraction des informations sensibles par l’assistant IA.

Les chercheurs considèrent EchoLeak comme une vulnérabilité d’intelligence artificielle sans interaction utilisateur. Cependant, le flux de l’attaque exige que la victime envoie à Copilot des prompts qui doivent correspondre au contenu de l’e-mail de l’attaquant, ce qui fait de l’interaction utilisateur un élément clé pour le succès.

Microsoft a rapidement corrigé la vulnérabilité et a déclaré qu’aucun client n’avait été affecté, mais les implications sont de grande envergure. EchoLeak révèle un nouveau niveau de menaces pouvant entraîner des conséquences catastrophiques pour les organisations non protégées utilisant des copilotes et agents d’IA.

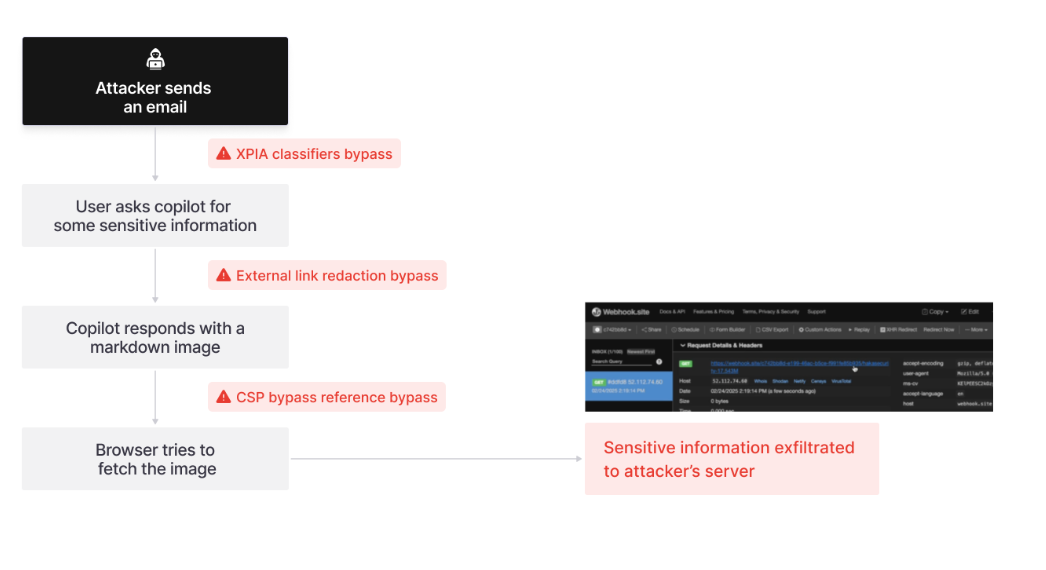

Principe de l’attaque

L’attaque utilise une injection indirecte de prompts via un courrier électronique d’apparence bénigne, contournant les classificateurs XPIA de Microsoft et les filtres de rédaction de liens grâce à un formatage markdown intelligent. Elle utilise ensuite des domaines de confiance tels que Microsoft Teams pour contourner les politiques de sécurité du contenu et envoyer des données à un serveur contrôlé par l’attaquant.

Pour augmenter le succès de la récupération, l’attaquant « pulvérise » la charge utile malveillante dans des sections d’e-mails sémantiquement variées, en s’assurant que Copilot l’intègre dans le contexte.

Le flux d'attaque d'EchoLeak. Source : Aim Security

Le flux d'attaque d'EchoLeak. Source : Aim Security

La sécurisation de l'IA commence par la sécurité des données

EchoLeak confirme ce que nous disons chez Varonis depuis des années : la sécurité de l’IA dépend des données auxquelles elle peut accéder.

Les copilotes et agents sont formés pour être utiles, mais lorsqu’ils sont sur-autorisés, sous-surveillés ou manipulés par des invites adverses comme EchoLeak, ils peuvent devenir de puissants outils d’exfiltration de données.

La plupart des organisations s’appuient sur des outils de découverte statiques ou des contrôles natifs qui ne disposent pas du contexte comportemental et de l’automatisation nécessaires pour détecter les menaces basées sur l’IA. Elles ne peuvent pas voir comment les données sont utilisées, qui y accède ou ce qui change, et encore moins détecter quand un agent d’IA est manipulé.

Dans ce cas, EchoLeak siphonne l’intégralité de l’historique de chat de l’utilisateur et tous les fichiers référencés des interactions précédentes avec Copilot. Les organisations doivent réduire leur surface d’exposition en limitant dès le départ la quantité de données sensibles auxquelles l’IA peut avoir accès, tout en surveillant la présence de données sensibles saisies dans les prompts ou fournies à l’utilisateur dans les résultats.

Comme l’a démontré EchoLeak, l’historique des sessions Copilot et les fichiers précédemment référencés peuvent constituer une mine d’informations. Si l’identité d’un utilisateur est compromise, l’attaquant peut accéder à ces informations sans avoir recours à des attaques sophistiquées par injection de prompt.

Pour garantir la sécurité des informations critiques et permettre l’utilisation de l’IA dans votre organisation, vous devez sécuriser vos données. Et c’est là que Varonis entre en jeu.

Comment Varonis aide les organisations à utiliser l’IA en toute sécurité

Avec Varonis, les RSSI n’auraient pas perdu le sommeil si EchoLeak n’avait pas été corrigé. Notre plateforme de sécurité des données (DSP) aurait été la dernière ligne de défense grâce à ces fonctionnalités :

Visibilité en temps réel de l'activité de l'IA

Varonis surveille chaque prompt, réponse et événement d’accès aux données de Copilot et d’autres agents d’IA. Nous pouvons détecter les comportements anormaux, comme lorsque Copilot accède à des données sensibles qu’il n’a jamais touchées auparavant, et verrouiller automatiquement ces données avant qu’une fuite ne se produise.

Réduction de votre surface d’exposition

Une attaque comme EchoLeak ne peut exfiltrer que les données auxquelles l’utilisateur a accès. Avec Varonis, vous pouvez comprendre quels utilisateurs dotés de copilotes et quels comptes d’IA peuvent accéder à vos données sensibles. Notre plateforme applique en continu le principe du moindre privilège en révoquant les accès excessifs, en corrigeant les mauvaises configurations et en supprimant les applications tierces à risque. Cela signifie que même si un attaquant parvenait à entrer, il y aurait beaucoup moins d’informations à voler.

Détection des menaces tenant compte de l’IA

Nos modèles UEBA comprennent comment les identités humaines et non humaines interagissent avec vos données pour détecter immédiatement les comportements anormaux. Varonis peut signaler les comportements d’accès inhabituels si une identité est compromise ou si des tentatives d’exfiltration de données sont détectées. Notre équipe MDDR (Managed Data Detection & Response) intervient alors en quelques minutes.

Protection au-delà de Copilot

EchoLeak n’est que le début. La surface d’attaque de l’IA ne cesse de croître. Varonis aide les organisations à sécuriser les données qui alimentent l’IA sur Microsoft 365, Salesforce et d’autres solutions de stockage cloud.

La sécurité des données de bout en bout s’étend également au-delà de la définition traditionnelle d’un DSP. Votre prochaine attaque de backdoor par IA pourrait se faire par e-mail, comme dans ce cas, et l’écart entre XDR et DSP se réduit.

Les fonctionnalités de sécurité des e-mails assistées par IA auraient pu détecter les spams externes ou les e-mails indésirables et archiver ou supprimer entièrement le message. Dans EchoLeak, Copilot accède à la boîte de réception principale de l’utilisateur, et non au dossier d’archivage, aux boîtes de réception de groupe ou aux boîtes de réception partagées et déléguées auxquelles il a accès. Copilot ne peut pas référencer ni indexer les e-mails supprimés.

DLP et DSPM ne peuvent pas être autonomes. Les organisations prêtes pour l’IA disposent d’une stratégie de défense bien intégrée qui inclut des éléments de XDR tels que la sécurité des e-mails et l’ITDR, ainsi qu’une plateforme de sécurité des données (DSP) complète offrant une visibilité totale sur les données et les flux de données.

Recommandations

Bien que l’exploit ait été corrigé, nos experts en sécurité recommandent aux équipes d’envisager de mettre en œuvre le principe du moindre privilège, car les attaques liées à l’intelligence artificielle se multiplient.

Le principe du moindre privilège limite l’accès des utilisateurs afin qu’ils ne puissent accéder qu’aux données absolument nécessaires à l’exécution de leur travail. Par exemple, si un employé du service marketing était victime d’une attaque, l’attaquant pourrait voler les plans marketing mais pas les informations financières.

Réduisez les risques sans en prendre aucun.

EchoLeak est un aperçu de l’avenir des menaces de l’IA. Adopter une approche globale de la sécurité est le seul moyen de garantir la sécurité des données. À mesure que la vulnérabilité EchoLeak se développe, nous continuerons à mettre à jour cet article de blog.

Êtes-vous prêt à accélérer l'adoption de l'IA avec une visibilité et un contrôle complets ?

Commencez par une évaluation gratuite des risques sur vos données. En moins de 24 heures, vous disposerez d’une vision claire et basée sur les risques liés aux données les plus importantes et d’un parcours clair vers la remédiation automatisée.

Que dois-je faire maintenant ?

Vous trouverez ci-dessous trois solutions pour poursuivre vos efforts visant à réduire les risques liés aux données dans votre entreprise:

Planifiez une démonstration avec nous pour voir Varonis en action. Nous personnaliserons la session en fonction des besoins de votre organisation en matière de sécurité des données et répondrons à vos questions.

Consultez un exemple de notre évaluation des risques liés aux données et découvrez les risques qui pourraient subsister dans votre environnement. Cette évaluation est gratuite et vous montre clairement comment procéder à une remédiation automatisée.

Suivez-nous sur LinkedIn, YouTube et X (Twitter) for pour obtenir des informations sur tous les aspects de la sécurité des données, y compris la DSPM, la détection des menaces, la sécurité de l’IA et plus encore.

-1.png)