Generative KI hat eine neue Welle an Produktivität ausgelöst und damit eine neue Kategorie von Sicherheitsrisiken.

Da KI-Tools und -Plattformen immer zugänglicher und leistungsfähiger werden, übernehmen Mitarbeitende sie ohne IT-Aufsicht. Tatsächlich hat unser Bericht zur Datensicherheit 2025 gezeigt, dass 98 % der Mitarbeitenden nicht genehmigte Apps in Anwendungsfällen von Shadow AI und Schatten-IT verwenden.

Sie mag harmlos erscheinen, doch Shadow AI kann Ihre sensitiven Daten offenlegen, die Compliance beeinträchtigen und nicht wahrgenommene Schwachstellen in Ihre Umgebung einführen. In diesem Artikel erfahren Sie, was Shadow AI ist, warum sie für Unternehmen riskant ist und wie Sie es angehen können, ohne Innovationen einzuschränken.

Was ist Shadow AI?

Shadow AI bezieht sich auf die Verwendung von Tools und Anwendungen der künstlichen Intelligenz durch Mitarbeitende ohne offizielle Genehmigung oder Verwaltung ihrer IT-Abteilungen. In ähnlicher Weise wie Schatten-IT hängt Shadow AI besonders mit generativen KI-Modellen, Agenten, Copiloten, Tools und anderen KI-Systeme zusammen, die keinen angemessenen Sicherheitsüberprüfungsprozesse unterzogen wurden.

Aufgrund des explosionsartigen Wachstums nutzerfreundlicher KI-Plattformen haben Mitarbeitende mühelos Zugriff auf leistungsstarke KI-Fähigkeiten. Allein mit ihrer Zweckmäßigkeit, Kosteneffizienz, den erweiterten Funktionen und dem Open-Source-Charakter sind KI-Tools für alle Mitarbeitenden, die ihre Produktivität steigern möchten, reizvoll, aber das birgt auch erhebliche verborgene Risiken. Das jüngste Verbot von Deepseek durch den US-Kongress hat ein Schlaglicht auf die kritischen Sicherheitsbedenken zu Shadow AI geworfen.

Die wachsende Sicherheitsbedrohung durch Shadow AI

Die Sicherheitsauswirkungen von Shadow AI gehen weit über typische Software-Risiken hinaus. Mitarbeitende, die Unternehmensdaten in nicht genehmigte KI-Systeme eingeben, könnten unbeabsichtigt sensible Informationen gegenüber externen Stellen mit unklaren Datenverarbeitungspraktiken offenlegen.

Hierauf sollten Sie achten, wenn Sie bestimmen, wie Ihre Daten von KI-Plattformen verarbeitet werden:

Bedenken bei der Datenverarbeitung

Lassen Sie uns die beliebte KI-Plattform DeepSeek untersuchen. Gemäß seiner Datenschutzrichtlinie verarbeitet DeepSeek die Prompts der Nutzer auf Servern in China.

Das bedeutet:

- Alle an die Plattform übermittelten Daten unterliegen den chinesischen Datenschutzgesetzen und -vorschriften

- Unternehmen haben möglicherweise Compliance-Probleme im Zusammenhang mit US-amerikanischen Regulierungsanforderungen

- Sensible Informationen könnten außerhalb des Sicherheitsperimeters Ihres Unternehmens verarbeitet werden

- Datensouveränität wird zu einem bedeutenden Anliegen für regulierte Branchen

Während Entwickler lokale DeepSeek-Instanzen auf abgeschotteten Servern hosten können, verwenden viele Mitarbeitende einfach die öffentlich verfügbare Version, ohne diese Auswirkungen zu berücksichtigen.

Exposure sensibler Informationen

Angenommen, ein Vertriebsmitarbeiter fügt beispielsweise einen Kundenvertrag in ein KI-Tool ein, um die wichtigsten Punkte für ein Meeting zusammenzufassen. Ohne es zu merken, hat er möglicherweise vertrauliche Preisstrukturen, Kundeninformationen und urheberrechtlich geschützte Bedingungen an Server weitergegeben, die außerhalb der Kontrolle des Unternehmens liegen. Diese Daten könnten in die Trainingsdaten der KI einbezogen oder von unbefugten Parteien abgerufen werden.

Der Vorgang an sich klingt harmlos, aber diese Art von unbeabsichtigtem Datenleck stellt eines der größten Risiken im Zusammenhang mit Shadow AI dar.

Warum traditionelle Verbote bei Shadow AI nicht funktionieren

Viele Unternehmen gingen das Shadow AI-Problem durch Einführung von Verboten für Tools wie DeepSeek. Regierungen und ganze Länder wie Italien haben Maßnahmen ergriffen und bestimmte KI-Plattformen als Schutz von den Risiken von Shadow AI blockiert.

Traditionelle Unternehmensverbote haben sich jedoch aus mehreren Gründen als schwer durchzusetzen erwiesen:

- Mitarbeitende finden Problemumgehungen, wenn sie meinen, dass KI die Produktivität steigern kann

- Persönliche Geräte und Heimnetzwerke bieten alternative Zugangspunkte

- Aufgrund der wachsenden Zahl von KI-Tools ist eine umfassende Blockierung unpraktisch

- Mitarbeitende verstehen möglicherweise die Sicherheitsauswirkungen ihres Handelns nicht

Nehmen Sie an unserem nächsten Webinar teil, Shadow AI im Rampenlicht.

Die einzigartige Herausforderung von Open-Source-KI.

Anders als die Bedenken über Anwendungen wie TikTok oder Hardware von Unternehmen wie Huawei stellen Open-Source-KI-Tools andere Sicherheitsherausforderungen dar.

Open-Source-Modelle:

- Sie ermöglichen Cyberkriminellen, massive Kampagnen aufgrund ihrer geringen Trainings- und Ausführungskosten effizienter zu starten

- Sie schaffen Herausforderungen für Unternehmen, die identifizieren möchten, wann und wie diese Tools genutzt werden.

- Sie verfügen über Code, der so geändert und bereitgestellt werden kann, dass er nicht erkannt wird

- Erhöhte Anfälligkeit für gezielte Angriffe aufgrund der Transparenz von Open-Source-Modellen

Effektive Strategien zur Risikominderung von Shadow AI

Es ist nicht alles Schwarzmalerei. Unternehmen können immer noch von den Vorteilen der KI profitieren. Anstatt alle KI-Tools zu blockieren oder zu untersagen, können Unternehmen diese Strategien zum Verwalten von Shadow AI implementieren und gleichzeitig die Vorteile von KI nutzen.

Entwickeln Sie klare KI-Richtlinien

Unternehmen können mit der Minderung von KI-Risiken beginnen, indem sie klare Richtlinien zu genehmigten KI-Tools und deren Verwendung festlegen und kommunizieren.

Zu den typischen Richtlinien gehören:

- Spezifische Protokolle für die Bearbeitung sensibler Informationen erstellen

- Definieren Sie Konsequenzen für die unbefugte Nutzung von KI-Tools

- Klare Kanäle für das Beantragen des Zugriffs auf neue KI-Tools festlegen

- Richtlinien zur Datenklassifizierung festlegen, um KI-spezifische Risiken zu berücksichtigen.

Ein Marketingteam könnte beispielsweise Richtlinien entwickeln, die zulassen, dass genehmigte KI-Tools zum Brainstorming Kampagnenkonzepten verwendet werden, aber vor der Implementierung von KI-generierten Inhalten eine menschliche Überprüfung erfordern.

Sichere Alternativen anbieten

Wenn Mitarbeitende Shadow AI nutzen, ist dies häufig ein Hinweis darauf, dass sie Fähigkeiten benötigen, die nicht über offizielle Kanäle bereitgestellt werden.

Um dem entgegenzuwirken, sollten Unternehmen:

- Sie Entwicklung isolierter Instanzen mit Open-Source-Code in Betracht ziehen.

- Bewerten Sie KI-Lösungen auf Unternehmensebene mit angemessenen Sicherheitskontrollen

- Abgeschottete Versionen implementieren, die keine Verbindung zu externen Servern herstellen.

- Erstellen Sie interne KI-Sandkästen, in denen Mitarbeiter sicher experimentieren können

Software-Entwicklungsteams können zum Beispiel von intern gehosteten Programmierungsassistenten profitieren, die bei Aufgaben helfen, ohne firmeneigenen Code gegenüber externen KI-Plattformen offenzulegen.

Schulung von Mitarbeitenden priorisieren

Viele Shadow AI-Risiken sind eher die Folge von fehlendem Bewusstsein als böswilliger Absicht. Unternehmen, die KI implementieren möchten, sind dafür verantwortliche, dass:

- Mitarbeitende über die Datensicherheitsrisiken im Zusammenhang mit KI-Tools informiert sind

- Konkrete Alternativen zu nicht genehmigten KI-Apps zur Verfügung stehen

- Die Konsequenzen der Weitergabe sensibler Informationen an KI-Modelle erläutert werden

- Einfache Rahmenbedingungen für die Entscheidung erstellt werden, wann die Verwendung von KI angemessen ist

Technische Kontrollen implementieren

Technische Lösungen verfügen über starke Fähigkeiten beim Verwalten von Shadow AI. Um ihre Umgebung für KI zu sichern, können Unternehmen:

- Tools zum Schutz vor Datenverlusten (DLP) einsetzen, um sensitive Daten zu identifizieren, die an KI-Plattformen weitergegeben werden

- Verwenden Sie DNS- und Web-Proxy-Überwachung, um unbefugte KI-Nutzung zu erkennen

- Das Least-Privilege-Prinzip implementieren, um das potenzielle Exposure zu minimieren

- Anwendungsintegrationen regelmäßig überprüfen, um Shadow AI-Tools zu identifizieren

Shadow AI-Innovation ermöglichen, aber mit Sicherheit

Der Schlüssel zum effektiven Management von Schatten-KI in einem Unternehmen liegt in dem Gleichgewicht zwischen Innovation und gleichzeitiger Beibehaltung von Sicherheit. Dieses Gleichgewicht zu finden bedeutet:

- Klare Pfade für Mitarbeitende zum Beantragen neuer KI-Fähigkeiten zu schaffen

- Risikobewertung-Frameworks speziell für KI-Tools festzulegen

- KI-Richtlinien bei technologischen Weiterentwicklungen regelmäßig zu überprüfen und zu aktualisieren

- Geschäftseinheiten in Entscheidungen zur KI-Governance einbeziehen

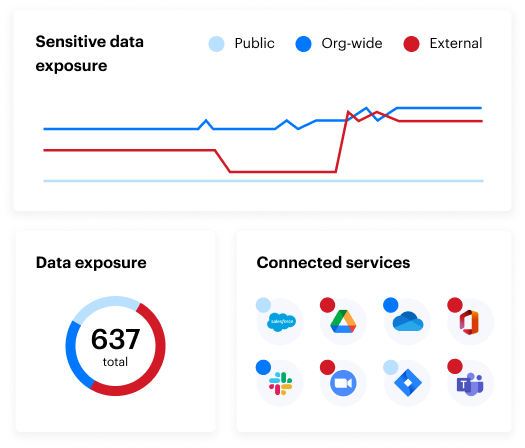

Entdecken und Verwalten von Shadow AI mit Varonis

Spezialisierte Tools wie Varonis ermöglichen es Unternehmen, die Nutzung von Shadow AI zu identifizieren und die damit verbundenen Herausforderungen durch folgende Funktionen anzugehen:

- Netzwerküberwachungsfähigkeiten, die Nutzung von KI-Tools über DNS- und Web-Proxy-Logs erkennen

- SSPM-Funktionalität, die ohne IT-Genehmigung automatisch Shadow AI-Apps und -Plugins identifiziert und entfernt, die in genehmigte SaaS-Anwendungen integriert sind

- Nachverfolgung von Nutzeraktivitäten, um zu bestimmen, welche Mitarbeitende KI-Apps installiert haben, wann sie dies getan haben und welche Aktionen ausgeführt wurden

- Tools zur Entdeckung und Klassifizierung von Daten , die Dateien, Quellcode, E-Mails und weitere Inhalte im Zusammenhang mit nicht genehmigten KI-Tools identifizieren können

Möchten Sie mehr über die Sicherheitslage Ihres Unternehmens erfahren? Nehmen Sie an unserer kostenlosen Datenrisikoprüfung teil.

Die verborgenen Risiken von Shadow: Häufig gestellte Fragen

Was ist Shadow AI?

Shadow AI bezieht sich auf Mitarbeitende, die KI-Tools und -Anwendungen ohne offizielle Genehmigung oder Verwaltung der IT-Abteilungen verwenden. Ähnlich wie Schatten-IT, wenn Mitarbeitende nicht genehmigte Software oder Hardware übernehmen, hängt Shadow AI besonders mit generative KI-Modellen, Tools zum maschinellen Lernen und anderen KI-Systemen zusammen, die keinen angemessenen Sicherheitsüberprüfungsprozessen unterzogen wurden.

Was sind die Risiken von Shadow AI?

Zu den Risiken von Shadow AI gehören:

- Exposure vertraulicher Unternehmensdaten gegenüber externen Einrichtungen mit unklaren Datenverarbeitungspraktiken

- Probleme mit der Einhaltung regulatorischer Anforderungen, wenn Daten in verschiedenen Gerichtsbarkeiten verarbeitet werden

- Bedenken in Bezug auf die Datenhoheit regulierter Branchen

- Unbeabsichtigtes Bekanntwerden von urheberrechtlich geschützten Informationen

- Mögliche Verarbeitung von Unternehmensdaten auf Servern mit unbekannten Sicherheitskontrollen.

Was sind Beispiele für Shadow AI?

Ein Beispiel für Shadow AI sind Mitarbeitende, die Tools wie ChatGPT oder Open-Source-LLMs (wie DeepSeek) verwenden, um Code zu schreiben, Daten zu analysieren, Marketinginhalte zu generieren oder Kundenverträge zusammenzufassen – alles ohne Genehmigung der IT oder Sicherheitsüberprüfung.

Wie können Organisationen die Nutzung von Shadow AI erkennen?

Shadow AI kann zu Verstößen gegen Vorschriften wie GDPR, HIPAA oder CCPA führen, wenn sensitive Daten in nicht genehmigten oder unregulierten Umgebungen verarbeitet werden, vor allem über internationale Grenzen hinweg.

Wie unterscheidet sich Shadow AI von Schatten-IT?

Shadow AI ist eine Untergruppe der Schatten-IT, die sich eindeutig auf die nicht genehmigte Verwendung von Tools der künstlichen Intelligenz konzentriert. Während zu Schatten-IT jede nicht genehmigte Hardware oder Software gehört, birgt Shadow AI einzigartige Risiken für Datenschutz und Modelltraining.

Wie soll ich vorgehen?

Vereinbaren Sie eine Demo mit uns, um Varonis in Aktion zu erleben. Wir passen die Session an die Datensicherheitsanforderungen Ihres Unternehmens an und beantworten alle Fragen.

Sehen Sie sich ein Beispiel unserer Datenrisikobewertung an und erfahren Sie, welche Risiken in Ihrer Umgebung lauern könnten. Varonis DRA ist völlig kostenlos und bietet einen klaren Weg zur automatischen Sanierung.

Folgen Sie uns auf LinkedIn, YouTubeund X (Twitter), um kurze Einblicke in alle Themen der Datensicherheit zu erhalten, einschließlich Data Security Posture Management (DSPM), Bedrohungserkennung, KI-Sicherheit und mehr.