La IA generativa ha generado una nueva ola de productividad y, con ella, una nueva categoría de riesgo para la seguridad.

A medida que las herramientas y plataformas de IA se vuelven más accesibles y poderosas, los empleados las están adoptando sin supervisión de TI. De hecho, nuestro Reporte sobre el estado de la seguridad de los datos en 2025 reveló que el 98 % de los empleados usan aplicaciones no autorizadas en casos de uso de shadow AI y TI oculta.

Aunque pueda parecer inofensiva, la shadow AI puede exponer sus datos confidenciales, socavar el cumplimiento e introducir vulnerabilidades no detectadas en su entorno. En este artículo, aprenderá qué es la IA oculta, por qué es arriesgada para las empresas y cómo abordarla sin sofocar la innovación.

¿Qué es la IA oculta?

La shadow AI (o IA oculta) se refiere al uso de herramientas y aplicaciones de inteligencia artificial por parte de los empleados sin la aprobación formal o la supervisión de sus departamentos de TI. Al igual que la TI oculta, la shadow AI involucra específicamente modelos generativos de IA, agentes, copilotos, herramientas y otros sistemas de IA que no han pasado por procesos de control de seguridad adecuados.

Con el crecimiento explosivo de las plataformas de IA fáciles de usar, los empleados pueden acceder fácilmente a potentes capacidades de IA. La gran comodidad, la rentabilidad, las funciones avanzadas y la naturaleza de código abierto de las herramientas de IA las hacen atractivas para cualquier empleado que busque aumentar su productividad, pero conllevan riesgos ocultos sustanciales. La reciente prohibición de Deepseek por parte del Congreso de EE. UU. puso de relieve las inquietudes críticas de seguridad de la shadow AI.

La creciente amenaza de seguridad de la shadow AI

Las consecuencias de la shadow AI para la seguridad van mucho más allá de los riesgos típicos del software. Los empleados que introducen datos corporativos en sistemas de IA no autorizados pueden exponer inadvertidamente información confidencial a entidades externas con prácticas de manejo de datos poco claras.

Esto es lo que debe tener en cuenta al determinar cómo las plataformas de IA gestionan sus datos:

Preocupaciones sobre el procesamiento de datos

Analicemos la popular plataforma de IA DeepSeek. De acuerdo con su política de privacidad, DeepSeek procesa las solicitudes de los usuarios en servidores ubicados en China.

Esto significa:

- Todos los datos enviados a la plataforma están sujetos a las leyes y regulaciones chinas de privacidad de datos

- Las organizaciones pueden enfrentar problemas de cumplimiento con los requisitos normativos de EE. UU.

- La información confidencial podría ser procesada fuera del perímetro de seguridad de su organización

- La soberanía de los datos se convierte en una preocupación significativa para las industrias reguladas

Aunque los desarrolladores pueden alojar instancias locales de DeepSeek en servidores aislados, muchos empleados simplemente utilizan la versión disponible públicamente sin considerar estas consecuencias.

Exposición de información confidencial

Supongamos, por ejemplo, que un representante de ventas pega el contrato de un cliente en una herramienta de IA para ayudar a resumir los puntos clave de una reunión. Sin darse cuenta, ha expuesto potencialmente estructuras de precios confidenciales, información de clientes y condiciones de propiedad exclusiva de la empresa a servidores fuera de su control. Estos datos podrían incorporarse a los datos de entrenamiento de la IA o partes no autorizadas podrían acceder a ellos.

El acto en sí parece bastante inocente, pero este tipo de filtración de datos involuntaria representa uno de los riesgos más significativos asociados con la shadow AI.

Por qué las prohibiciones tradicionales no funcionan con la shadow AI

Muchas organizaciones abordaron la shadow AI mediante la implementación de prohibiciones en herramientas como DeepSeek. Gobiernos y países enteros, como Italia, han tomado medidas para bloquear ciertas plataformas de IA para protegerse contra los riesgos de la shadow AI.

Sin embargo, las prohibiciones corporativas tradicionales han demostrado ser difíciles de aplicar por varias razones:

- Los empleados encuentran soluciones alternativas cuando creen que la IA los ayudará con la productividad

- Los dispositivos personales y las redes domésticas ofrecen puntos de acceso alternativos

- El creciente número de herramientas de IA hace que el bloqueo exhaustivo sea poco práctico

- Es posible que los empleados no comprendan las consecuencias de sus acciones para la seguridad

Acompáñenos en nuestro próximo seminario web, Echar luz sobre la shadow AI.

El desafío único de la IA de código abierto

A diferencia de las inquietudes sobre aplicaciones como TikTok o hardware de empresas como Huawei, las herramientas de IA de código abierto presentan diferentes desafíos de seguridad.

Modelos de código abierto:

- Permiten que los ciberdelincuentes lancen campañas masivas de manera más eficiente debido a su bajo costo de entrenamiento y operación

- Crear desafíos para las organizaciones que buscan identificar cuándo y cómo se están utilizando estas herramientas

- Tienen código que puede ser modificado e implementado de manera que evite la detección

- Aumenta la vulnerabilidad a los ataques dirigidos debido a la transparencia de los modelos de código abierto

Estrategias eficaces de mitigación de riesgos de la shadow AI

No todo es pesimismo; las organizaciones todavía pueden aprovechar los beneficios de la IA. En lugar de bloquear o prohibir todas las herramientas de IA, las organizaciones pueden implementar estas estrategias para gestionar los riesgos de la shadow AI y, al mismo tiempo, aprovechar los beneficios de la IA.

Desarrolle políticas claras de IA

Las organizaciones pueden comenzar a mitigar el riesgo de la IA estableciendo y comunicando pautas claras sobre las herramientas de IA aprobadas y su uso.

Las políticas típicas incluyen:

- Crear protocolos específicos para el manejo de información sensible

- Defina las consecuencias del uso no autorizado de herramientas de IA

- Establezca canales claros para solicitar acceso a nuevas herramientas de IA

- Actualizar las políticas de clasificación de datos para considerar los riesgos específicos de la IA

Por ejemplo, un equipo de marketing podría desarrollar pautas que permitan el uso de herramientas de IA aprobadas para lluvias de ideas sobre conceptos de campañas, pero que requieran una revisión humana antes de implementar cualquier contenido generado por IA.

Ofrezca alternativas seguras

Cuando los empleados recurren a la shadow AI, a menudo indica que necesitan capacidades que no se proporcionan a través de los canales oficiales.

Para combatir esto, las organizaciones deberían:

- Considere crear instancias aisladas utilizando código abierto

- Evalúe soluciones de IA de nivel empresarial con controles de seguridad adecuados

- Implemente versiones aisladas que no se conecten a servidores externos

- Cree sandboxes internos de IA donde los empleados puedan experimentar de manera segura

Los equipos de desarrollo de software, por ejemplo, pueden beneficiarse de asistentes de codificación alojados internamente que ayudan con las tareas sin exponer código de propiedad exclusiva a plataformas de IA externas.

Dar prioridad a la capacitación de los empleados

Muchos riesgos de la shadow AI derivan de la falta de concienciación, más que de una intención maliciosa. Es responsabilidad de las organizaciones que buscan implementar IA:

- Educar al personal sobre los riesgos de seguridad de datos asociados con las herramientas de IA

- Proporcione alternativas claras a las aplicaciones de IA no autorizadas

- Explicar las consecuencias de compartir información confidencial con modelos de IA

- Crear marcos de decisión sencillos para cuándo es apropiado el uso de la IA

Implementar controles técnicos

Las soluciones técnicas ofrecen sólidas capacidades en la gestión de la shadow AI. Para asegurar su entorno para la IA, las organizaciones pueden:

- Desplegar herramientas de Data Loss Prevention (DLP) para identificar datos confidenciales que se comparten con plataformas de IA

- Utilice la supervisión de DNS y proxy web para detectar el uso no autorizado de IA

- Implementar el acceso de privilegios mínimos para minimizar la posible exposición

- Auditar periódicamente las integraciones de aplicaciones para identificar herramientas de shadow AI

Habilitación de la innovación de la shadow AI, pero con seguridad

La clave para gestionar la shadow AI de manera efectiva en una organización radica en equilibrar la innovación y el mantenimiento de la seguridad. Encontrar este equilibrio significa:

- Crear vías claras para que los empleados soliciten nuevas capacidades de IA

- Establecer marcos de evaluación de riesgos específicamente para herramientas de IA

- Revisar y actualizar periódicamente las políticas de IA a medida que evoluciona la tecnología

- Involucrar a las unidades de negocio en las decisiones de gobernanza de la IA

Descubrir y gestionar la shadow AI con Varonis

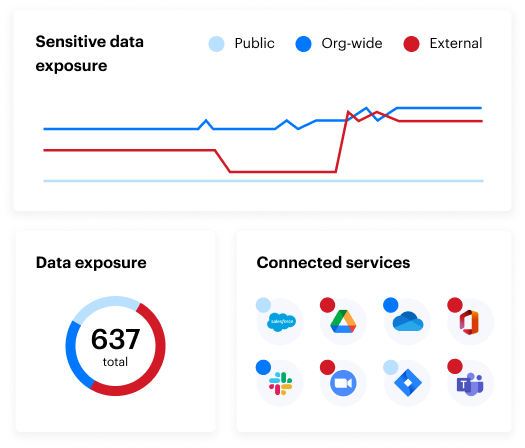

Las herramientas especializadas como Varonis permiten a las organizaciones identificar el uso de la shadow AI y abordar sus desafíos a través de funciones como:

- Capacidades de monitoreo de red que detectan el uso de herramientas de IA a través de registros DNS y web proxy

- Funcionalidad de SSPM que identifica y elimina automáticamente aplicaciones y complementos de shadow AI integrados en aplicaciones SaaS autorizadas sin la aprobación de TI

- Seguimiento de la actividad de los usuarios para determinar qué empleados instalaron aplicaciones de IA, cuándo lo hicieron y qué acciones llevaron a cabo

- Herramientas de descubrimiento y clasificación de datos que pueden identificar archivos, código fuente, correos electrónicos y otros contenidos relacionados con herramientas de IA no autorizadas

¿Le interesa conocer más sobre la postura de seguridad de datos de su organización? Haga nuestra Evaluación de riesgo sobre los datos gratuita.

Los riesgos ocultos de la shadow AI: preguntas frecuentes

¿Qué es la IA oculta?

La expresión "shadow AI" se refiere a los empleados que utilizan herramientas y aplicaciones de inteligencia artificial sin la aprobación formal o la supervisión de los departamentos de TI. Similar a la TI oculta, en cuyo caso los empleados adoptan software o hardware no autorizados, la shadow AI implica específicamente usar modelos de IA generativa, herramientas de aprendizaje automático y otros sistemas de IA que no han pasado por los procesos de verificación de seguridad adecuados

¿Cuáles son los riesgos de la shadow AI?

Los riesgos de la shadow AI incluyen:

- Exposición de datos corporativos confidenciales a entidades externas con prácticas poco claras de manejo de datos

- Problemas de cumplimiento con los requisitos normativos cuando los datos se procesan en diferentes jurisdicciones

- Inquietudes sobre la soberanía de los datos en las industrias reguladas

- Fuga involuntaria de información confidencial

- Posible procesamiento de datos de la empresa en servidores con controles de seguridad desconocidos.

¿Cuáles son ejemplos de shadow AI?

Un ejemplo de shadow AI es que los empleados usen herramientas como ChatGPT o LLM de código abierto (como DeepSeek) para programar, analizar datos, generar contenido de marketing o resumir contratos de clientes, todo sin la aprobación ni la revisión de seguridad de TI.

¿Cómo pueden las organizaciones detectar el uso de shadow AI?

La shadow AI puede resultar en el incumplimiento de regulaciones como el GDPR, la HIPAA o la CCPA si los datos confidenciales se procesan en entornos no autorizados o no regulados, especialmente en otros países.

¿En qué se diferencia la shadow AI de la TI oculta?

La shadow AI es una subcategoría de TI oculta que se concentra explícitamente en el uso no autorizado de herramientas de inteligencia artificial. Mientras que la TI oculta incluye cualquier hardware o software no aprobado, la shadow AI presenta riesgos únicos para la privacidad de los datos y el entrenamiento de modelos.

¿Qué pasos debo seguir ahora?

Programe una demostración con nosotros Vea a Varonis en acción en una sesión personalizada según las necesidades específicas de seguridad de datos de su organización. Estaremos encantados de responder a todas sus preguntas.

Revise un ejemplo de nuestra evaluación de riesgo sobre los datos (DRA) Conozca los riesgos que podrían estar presentes en su entorno. La DRA de Varonis es completamente gratuita y ofrece un camino claro hacia la remediación automatizada.

Síganos en LinkedIn, YouTube, and X (Twitter) Obtenga información detallada sobre la seguridad de datos, incluyendo la administración de la postura de seguridad de datos (DSPM), la detección de amenazas, la seguridad de la IA y mucho más.