A IA generativa provocou uma nova onda de produtividade e, com ela, uma nova categoria de risco de segurança.

À medida que as ferramentas e plataformas de IA se tornam mais acessíveis e poderosas, os funcionários estão adotando-as sem supervisão do departamento de TI. Na verdade, nosso Relatório sobre o Estado da Segurança de Dados de 2025 revelou que 98% dos funcionários usam aplicativos não autorizados em casos de uso de Shadow AI e Shadow IT.

Embora possa parecer inofensiva, a Shadow AI pode expor seus dados confidenciais, prejudicar a conformidade e introduzir vulnerabilidades invisíveis no seu ambiente. Neste artigo, você aprenderá o que é a Shadow AI, por que ela é arriscada para as empresas e como lidar com ela sem sufocar a inovação.

O que é a Shadow AI?

A Shadow AI refere-se ao uso de ferramentas e aplicativos de inteligência artificial pelos funcionários sem a aprovação formal ou a governança dos respectivos departamentos de TI. Assim como a shadow IT, a shadow AI envolve especificamente modelos generativos de IA, agentes, copilotos, ferramentas e outros sistemas de IA que não passaram por processos de verificação de segurança adequados.

Com o crescimento explosivo de plataformas de IA fáceis de usar, os funcionários podem acessar recursos poderosos de IA. A pura conveniência, a relação custo-benefício, os recursos avançados e a natureza de código aberto das ferramentas de IA as tornam atraentes para qualquer funcionário que queira aumentar a produtividade, mas elas trazem grandes riscos ocultos. O recente banimento do Deepseek pelo Congresso dos EUA destacou as preocupações críticas de segurança com a Shadow AI.

A crescente ameaça à segurança da Shadow AI

As implicações de segurança da Shadow AI vão muito além dos riscos típicos de software. Funcionários que inserem dados corporativos em sistemas de IA não autorizados podem inadvertidamente expor informações sensíveis a entidades externas com práticas de tratamento de dados pouco claras.

Veja o que você deve observar ao determinar como seus dados são tratados pelas plataformas de IA:

Preocupações com o processamento de dados

Vamos analisar a popular plataforma de IA DeepSeek. De acordo com a política de privacidade, o DeepSeek processa as solicitações dos usuários em servidores localizados na China.

Isso significa:

- Todos os dados enviados para a plataforma estão sujeitos às leis e regulamentos chineses de privacidade de dados

- As organizações podem enfrentar problemas de conformidade com os requisitos regulatórios dos EUA

- Informações confidenciais podem ser processadas fora do perímetro de segurança da sua organização

- A soberania dos dados torna-se uma preocupação para as indústrias regulamentadas

Embora os desenvolvedores possam hospedar instâncias locais do DeepSeek em servidores isolados, muitos funcionários simplesmente usam a versão disponível publicamente sem considerar essas implicações.

Exposição de informações sensíveis

Digamos, por exemplo, que um representante de vendas copie e cole um contrato de cliente em uma ferramenta de IA para ajudar a resumir os principais pontos para uma reunião. Sem perceber, ele potencialmente expôs estruturas de preços confidenciais, informações de clientes e termos proprietários a servidores fora do controle da empresa. Esses dados podem ser incorporados aos dados de treinamento da IA ou acessados por partes não autorizadas.

O ato em si parece bastante inocente, mas esse tipo de vazamento inadvertido de dados representa um dos riscos mais significativos associados à Shadow AI.

Por que as proibições tradicionais não funcionam na Shadow AI

Muitas organizações enfrentaram a Shadow AI implementando proibições em ferramentas como o DeepSeek. Governos e países inteiros, como a Itália, tomaram medidas para bloquear determinadas plataformas de IA para se protegerem contra os riscos da Shadow AI.

As proibições corporativas tradicionais, no entanto, têm se mostrado difíceis de serem aplicadas por vários motivos:

- Os funcionários encontram soluções alternativas quando acreditam que a IA irá ajudar na produtividade

- Dispositivos pessoais e redes domésticas oferecem pontos de acesso alternativos

- O número cada vez maior de ferramentas de IA torna impraticável o bloqueio abrangente

- Os funcionários podem não compreender as implicações de segurança das próprias ações

Junte-se a nós para o nosso próximo webinar, Shining a Light on Shadow AI.

O desafio único da IA de código aberto

Ao contrário das preocupações com aplicativos como o TikTok ou hardware de empresas como a Huawei, as ferramentas de IA de código aberto apresentam desafios de segurança diferentes.

Modelos de código aberto:

- Permitem que os cibercriminosos lancem campanhas massivas de forma mais eficiente devido ao baixo custo de treinamento e execução

- Criam desafios para organizações que procuram identificar quando e como essas ferramentas estão sendo utilizadas

- Possuem código que pode ser modificado e implantado de formas que evitem a detecção

- Aumento da vulnerabilidade a ataques direcionados devido à transparência dos modelos de código aberto

Estratégias eficazes de mitigação de riscos da Shadow AI

Nem tudo é desgraça e tristeza; as organizações ainda podem colher os benefícios da IA. Em vez de bloquear ou banir todas as ferramentas de IA, as organizações podem implementar essas estratégias para gerenciar os riscos da Shadow AI e, ao mesmo tempo, aproveitar os benefícios da IA.

Desenvolva políticas claras de IA

As organizações podem começar a mitigar o risco da IA definindo e comunicando diretrizes claras sobre as ferramentas de IA aprovadas e o uso.

As políticas típicas incluem:

- Criar protocolos específicos para lidar com informações confidenciais

- Defina as consequências para o uso não autorizado de ferramentas de IA

- Definir canais claros para solicitar acesso a novas ferramentas de IA

- Atualizar as políticas de classificação de dados para levar em conta os riscos específicos da IA

Por exemplo, uma equipe de marketing pode desenvolver diretrizes que permitam o uso de ferramentas de IA aprovadas para a geração de ideias de conceitos de campanha, mas que exijam revisão humana antes de implementar qualquer conteúdo gerado por IA.

Ofereça alternativas seguras

Quando os funcionários recorrem à Shadow AI, isso geralmente indica que eles precisam de capacidades não fornecidas pelos canais oficiais.

Para combater isso, as organizações devem:

- Considere criar instâncias isoladas usando o código-fonte aberto

- Avalie soluções de IA de nível empresarial com controles de segurança apropriados

- Implemente versões isoladas que não se conectam a servidores externos

- Criar sandboxes internos de IA onde os funcionários possam experimentar com segurança

As equipes de desenvolvimento de software, por exemplo, podem se beneficiar de assistentes de codificação hospedados internamente que auxiliam nas tarefas sem expor código proprietário a plataformas de IA externas.

Priorize a formação dos funcionários

Muitos riscos obscuros de IA decorrem da falta de conscientização e não de intenções maliciosas. É responsabilidade das organizações que buscam implementar a IA para:

- Educar a equipe sobre os riscos de segurança de dados associados às ferramentas de IA

- Forneça alternativas claras aos aplicativos de IA não autorizados

- Explique as implicações de compartilhar informações confidenciais com modelos de IA

- Criar estruturas simples de decisão para quando o uso da IA for apropriado

Implementar controles técnicos

As soluções técnicas oferecem recursos sólidos para gerenciar a Shadow AI. Para proteger o ambiente para IA, as organizações podem:

- Implante ferramentas de Data Loss Prevention (DLP) para identificar dados sensíveis que estão sendo compartilhados com plataformas de IA

- Use o monitoramento de DNS e proxy da web para detectar uso não autorizado de IA

- Implementar acesso com privilégios mínimos para minimizar a exposure potencial

- Audite regularmente as integrações de aplicativos para identificar ferramentas de Shadow AI

Possibilitar a inovação da Shadow AI, mas com segurança

O segredo para gerenciar a Shadow AI de forma eficaz em uma organização está em equilibrar a inovação e a manutenção da segurança. Encontrar esse equilíbrio significa:

- Criar caminhos claros para os funcionários solicitarem novos recursos de IA

- Estabelecer estruturas de avaliação de risco especificamente para ferramentas de IA

- Revisar e atualizar regularmente as políticas de IA à medida que a tecnologia evolui

- Envolver as unidades de negócios nas decisões de governança de IA

Conhecer e gerenciar a Shadow AI com a Varonis

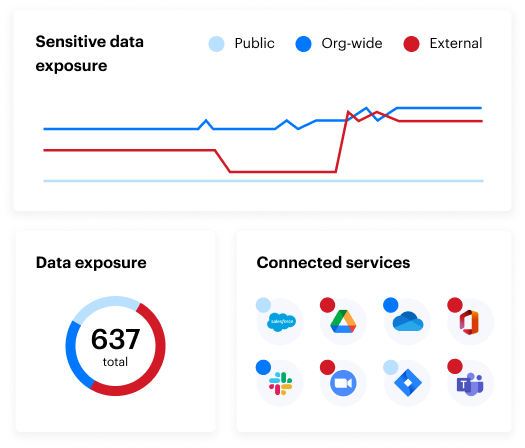

Ferramentas especializadas, como a Varonis, permitem que as organizações identifiquem o uso de Shadow AI e enfrentem os desafios por meio de recursos como:

- Capacidades de monitoramento de rede que detectam o uso de ferramentas de IA por meio de logs de DNS e proxy da web

- Funcionalidade SSPM que identifica e remove automaticamente aplicativos e plug-ins de IA paralela integrados em aplicativos SaaS sancionados sem aprovação da TI

- Rastreamento da atividade do usuário para determinar quais funcionários instalaram aplicativos de IA, quando o fizeram e quais ações foram realizadas

- Ferramentas de descoberta e classificação de dados que podem identificar arquivos, código-fonte, e-mails e outros conteúdos relacionados a ferramentas de IA não autorizadas

Que saber mais sobre a postura de segurança de dados da sua organização? Leia nosso relatório de risco de dados gratuito.

Os riscos ocultos da Shadow AI: Perguntas Frequentes

O que é a Shadow AI?

A Shadow AI refere-se a funcionários usando ferramentas e aplicativos de inteligência artificial sem a aprovação formal ou a governança dos respectivos departamentos de TI. Semelhante à shadow IT, onde os funcionários adotam software ou hardware não autorizado, a shadow AI envolve especificamente modelos de IA generativa, ferramentas de aprendizado de máquina e outros sistemas de IA que não passaram por processos adequados de verificação de segurança

Quais são os riscos da Shadow AI?

Os riscos da Shadow AI incluem:

- Exposure de dados corporativos confidenciais a entidades externas com práticas de tratamento de dados pouco claras

- Questões de conformidade com os requisitos regulatórios quando os dados são processados em diferentes jurisdições

- Preocupações com a soberania de dados para indústrias regulamentadas

- Vazamento acidental de informações proprietárias

- Possível processamento de dados da empresa em servidores com controles de segurança desconhecidos.

Quais são os exemplos de Shadow AI?

Um exemplo de Shadow AI seriam os funcionários que usam ferramentas como o ChatGPT ou LLMs de código aberto (como o DeepSeek) para escrever código, analisar dados, gerar conteúdo de marketing ou resumir contratos de clientes, tudo sem a aprovação da TI ou a revisão de segurança.

Como as organizações podem detectar o uso de Shadow AI?

A Shadow AI pode resultar em não conformidade com regulamentos como GDPR, HIPAA ou CCPA se dados confidenciais forem processados em ambientes não autorizados ou não regulamentados, especialmente através de fronteiras internacionais.

Qual é a diferença entre Shadow AI e Shadow IT?

A Shadow AI é um subconjunto da Shadow IT focado explicitamente no uso não autorizado de ferramentas de inteligência artificial. Embora a shadow IT inclua qualquer hardware ou software não aprovado, a shadow AI apresenta riscos únicos de privacidade de dados e treinamento de modelos.

O que devo fazer agora?

Agende uma demonstração conosco: Veja a usabilidade de Varonis em uma sessão personalizada com base nas necessidades de segurança de dados da sua organização. Responderemos a todas as suas perguntas.

Veja um exemplo do nosso Relatório de Risco de Dados: Conheça as ameaças que podem permanecer no seu ambiente. O Relatório da Varonis é gratuito e demonstra claramente como realizar a remediação automatizada.

Siga-nos no LinkedIn, YouTube e X (Twitter): Obtenha insights detalhados sobre todos os aspectos da segurança de dados, incluindo DSPM, detecção de ameaças, segurança de IA, entre outros.